вытащить html код с сайта

Как полностью скопировать сайт, если его исходный код замусорен и создан в онлайн-конструкторе?

Есть задача полностью скопировать один из сайтов, чтобы потом его перевести на русский язык и немного доработать, встроив в него свой дополнительный программный код. Часть страниц потом генерируется динамически (каталог, меню и др)

Сайт, который нужно скопировать, на первый взгляд выглядит просто, и поначалу кажется, что его копирование не составит большого труда. С копированием сайтов, я уже имел дело. В общем задача сводится к тому, чтобы с помощью своего программного движка сгенерировать тот же HTML код, что у источника. А затем поправлять CSS стили и делать свои дополнительные вставки.

В результате исходный HTML код имеет совершенно нечитаемую для человека конструкцию.

К пример только один из тегов описывается десятками классов.

Дополнительно HTML код одной страницы ссылается на десяток сторонних стилей и десяток сторонних скриптов, часть из-которых явно не используется, и подключена онлайн-конструктором на всякий случай. К примеру подключаются стили и скрипты, чтобы смотреть фото, чтобы смотреть видео, чтобы случать музыку итп. Хотя никакой музыки на сайте и в помине нет. И сами стили и скрипты подключаются частично нормальным объявлением, а частично одни скрипты, подгружают другие сторонние CSS и JS файлы. Плюс большая часть кода отображается в плохочитаемом виде (слеплена без пробелов и переносов). И еще в качестве антибонуса, часть верстки меняется скриптами. Т.е. к примеру в зависимости от ширины окна браузера вертикальное меню превращается в горизонтальное. Но это реализовано не на CSS, а JS скрипты в онлайне меняют код, дописывая целые HTML блоки или убирая их. Т.е. анализ верстки затруднен.

Получается, что код сайта с одной стороны открыт, но с другой стороны там столько мусора, что чтобы разобраться даже по одному элементу какой класс CSS за что отвечает, требуется очень много времени. CSS cтили друг друга переопределяют, длинная цепочка переопределений с часто малозначимыми именами классов итп. Отделить полезную часть кода от мусора пока не знаю как.

Подскажите, есть ли какие-нибудь инструменты, чтобы облегчить задачу копирования сайта с замусоренным исходным HTML/CSS кодом? Для начала хотя бы скопировать верстку и CSS как-нибудь. А потом уже нужно будет, разбираться, можно ли скопировать скрипты.

Вытащить элемент из другого сайта и вставить в текущий

Хочу вытащить document.getElementsByClassName(«tl-desc»).innerText из ‘https://www.userbenchmark.com/Search?searchTerm=’+model и вставить его в document.querySelectorAll(«div[class=»product-info__title-link»] a[class=»ui-link»]»).innerText текущего сайта. Пытался найти информацию в интернете, но ничего не получается, даже console.log ничего не выводит. Как это сделать?

Помощь в написании контрольных, курсовых и дипломных работ здесь.

Каким образом можно поставить себе на сайт кол-во фотографий в альбоме в вк?

Как вытащить видео-трансляцию со стороннего сайта и вставить ее на свой сайт?

Подскажите как это можно сделать? Например с сайта какого-нибудь телеканала.

Добавлено через 56 минут

.

Я бы использовала селектор класса, а не селектор атрибута:

Добавлено через 21 минуту

Еще можно попытаться обработать ошибку с помощью метода fail

И что это значит? Dns запрещает мне изменять моё отображение сайта?

Добавлено через 14 минут

На e-katalog такая ошибка:

На всех этих ресурсах скорее всего не настроена CORS либо настроена на блокировку доступа. Я попробовал получить доступ через iframe и там cors

Но вот php этот CORS побоку, вот только нормального парсера html под php я не знаю DomDocument нормально ищет по id а классы через DomXPath как то не очень. Придется как то придумать как сначала загрузить страницу, а потом подгрузить нужный контент.

Добавлено через 24 минуты

А вообще у yandex.market есть API для работы с товарами и поиском по магазинам

Добавлено через 34 минуты

Но я бы не рекомендовал использовать file_get_contents на продакшн сайте для этой цели, так как он может подвесить сессию, лучше запускать стороннюю программу которая вернет файл с содержимым сайта и его потом прочитать.

Подходы к извлечению данных из веб-ресурсов

В предыдущей статье мы рассмотрели основные понятия и термины в рамках технологии Data Mining. Сегодня более детально остановимся на Web Mining и подходах к извлечению данных из веб-ресурсов.

Анализ DOM дерева

Этот подход основывается на анализе DOM дерева. Используя этот подход, данные можно получить напрямую по идентификатору, имени или других атрибутов элемента дерева (таким элементом может служить параграф, таблица, блок и т.д.). Кроме того, если элемент не обозначен каким-либо идентификатором, то к нему можно добраться по некоему уникальному пути, спускаясь вниз по DOM дереву, например:

или пройтись по коллекции однотипных элементов, например:

Data Extracting SDK использует Microsoft.mshtml для анализа DOM дерева, но является «надстройкой» над библиотекой для удобства работы:

UriHtmlProcessor proc = new UriHtmlProcessor( new Uri ( «http://habrahabr.ru/new/page1/» ));

proc.Initialize();

Следующим эволюционным этапом анализа DOM дерева является использования XPath — т.е. путей, которые широко используются при парсинге XML данных. Суть данного подхода в том, чтобы с помощью некоторого простого синтаксиса описывать путь к элементу без необходимости постепенного движения вниз по DOM дереву. Данный подход использует всеми известная библиотека jQuery и библиотека HtmlAgilityPack:

HtmlDocument doc = new HtmlDocument();

doc.Load( «file.htm» );

foreach (HtmlNode link in doc.DocumentElement.SelectNodes( «//a[@href» ])

<

HtmlAttribute att = link[ «href» ];

att.Value = FixLink(att);

>

doc.Save( «file.htm» );

Парсинг строк

Несмотря на то, что этот подход нельзя применять для написания серьезных парсеров, я о нем немного расскажу.

Иногда данные отображаются с помощью некоторого шаблона (например, таблица характеристик мобильного телефона), когда значения параметров стандартные, а меняются только их значения. В таком случае данные могут быть получены без анализа DOM дерева, а путем парсинга строк, например, как это сделано в Data Extracting SDK:

Компания: Microsoft

Штаб-квартира: Редмонд

// output

// company = «Microsoft»

// location = «Редмонт»

Использование набора методов для анализа строк иногда (чаще — простых шаблонных случаях) более эффективный чем анализ DOM дерева или XPath.

Регулярные выражения и парсинг XML

Очень часто видел, когда HTML полностью парсили с помощью регулярных выражений. Это в корне неверный подход, так как таким образом можно получить больше проблем, чем пользы.

Регулярные выражения необходимо использоваться только для извлечения данных, которые имеют строгий формат — электронные адреса, телефоны и т.д., в редких случаях — адреса, шаблонные данные.

Еще одним неэффективным подходом является рассматривать HTML как XML данные. Причина в том, что HTML редко бывает валидным, т.е. таким, что его можно рассматривать как XML данные. Библиотеки, реализовавшие такой подход, больше времени уделяли преобразованию HTML в XML и уже потом непосредственно парсингу данных. Поэтому лучше избегайте этот подход.

Визуальный подход

В данный момент визуальный подход находится на начальной стадии развития. Суть подхода в том, чтобы пользователь мог без использования программного языка или API «настроить» систему для получения нужных данных любой сложности и вложенности. О чем-то похожем (правда применимым в другой области) — методах анализа веб-страниц на уровне информационных блоков, я уже писал. Думаю, что парсеры будущего будут именно визуальными.

Проблемы и общие рекомендации

Проблемы при парсинге HTML данных — использование JavaScript / AJAX / асинхронных загрузок очень усложняют написание парсеров; различные движки для рендеринга HTML могут выдавать разные DOM дерева (кроме того, движки могут иметь баги, которые потом влияют на результаты работы парсеров); большие объемы данных требуют писать распределенные парсеры, что влечет за собой дополнительные затраты на синхронизацию.

Нельзя однозначно выделить подход, который будет 100% применим во всех случаях, поэтому современные библиотеки для парсинга HTML данных, как правило, комбинируют, разные подходы. Например, HtmlAgilityPack позволяет анализировать DOM дерево (использовать XPath), а также с недавних пор поддерживается технология Linq to XML. Data Extracting SDK использует анализ DOM дерева, содержит набор дополнительных методов для парсинга строк, а аткже позволяет использовать технологию Linq для запросов в DOM модели страницы.

На сегодня абсолютным лидером для парсинга HTML данных для дотнетчиков является библиотека HtmlAgilityPack, но ради интереса можно посмотреть и на другие библиотеки.

JavaScript | Как получить все ссылки на HTML-странице?

Все ссылки на HTML-странице

Вернёт объект-прототип класса HTMLCollection с объектами ссылок (HTML-элементами ). Эта команда для разработчиков, которые понимают, что делать дальше.

Все ссылки на HTML-странице из консоли браузера, работающего на Chrome

$x(path) возвращает массив элементов DOM, соответствующих заданному выражению XPath.

Все ссылки на HTML-странице с выводом результатов на текущую страницу (в эту же вкладку браузера)

Для удобства. Выведет в столбик все адреса из ссылок в текущий документ. Разметка страницы перезапишется, результат легко закинуть в EXCEL или WORD или туда, куда тебе это нужно.

Куда вводить эти команды?

Открываете HTML-страницу, с которой хотите получить все веб-ссылки. Включаете «Инструменты разработчика» в браузере (CTRL + SHIFT + i). Находите вкладку «Console«. Тыкаете курсор в белое поле справа от синей стрелочки. Вставляете команду. Жмёте клавишу ENTER.

Для тех кто не понял длинную строчку кода выше, предлагаю упрощённую для понимания версию. Пошаговая инструкция по извлечению ссылок со страницы, и видео ниже.

Специально для тебя написана статья «JavaScript | Список ссылок сайта«. Она о том, каким образом ты можешь собрать все ссылки любого сайта при помощи JavaScript, который работает на ЧПУ-адресах.

Видео инструкция по получению всех ссылок на HTML-странице

Этот метод также работает и с XML-документами.

Реклама на странице

Пошаговая инструкция — для тех кто хочет разобраться в вопросе сбора ссылок

1. Открываем страницу сайта в браузере

Для примера возьмём страницу любого интернет-магазина с товарами. Пусть это будут фены. На странице со списком фенов будет большое количество ссылок, как на сами товары, так и на пункты навигации по сайту.

2. Открываем инструменты разработчика

Включаете «Инструменты разработчика» в браузере (CTRL + SHIFT + i). Мы не будем использовать редакторы кода т. к. задача очень примитивная. С редактором кода нужно постоянно прыгать из окна в окно — это неудобно. Мы будем пользоваться консолью браузера для ввода команд JavaScript.

3. Находим в инструментах вкладку Console

Ввод команд осуществляется в белое поле справа от синей стрелочки в форме уголка 90 градусов. Иногда, при вводе команд, будут ошибки самого ввода. Любые ошибки ввода команд легко исправлять простым нажатием клавиши «вверх» на клавиатуре (стрелочка вверх) и исправлением команды. Опечатки возможны и неизбежны.

В консоли мы сразу будем видеть результат своей работы.

4. Получаем HTML-коллекцию элементов A

Вводим команду для получения всех HTML-элементов с текущий страницы (с текущего документа) в браузере:

Выводим переменную a в консоль:

5. Преобразовываем HTML-коллекцию в Массив

Выводим переменную a в консоль:

Эта операция необходима для того, чтобы иметь возможность трансформировать элементы массива при помощи метода прототипов объекта Array — map()

С коллекций HTML мы не сможем так работать.

6. Достаём из элементов массива значения ключа href

Если бы нас интересовали относительные ссылки, то мы бы собирали новый массив из ключей «pathname«.

Выводим переменную a в консоль:

7. Массив перегоняем в строку и добавляем разделитель между элементами

Выводим переменную a в консоль:

8. Выводим строку на страницу текущего документа

Эта операция очистит содержимое страницы и выведет список. При обновлении страницы в браузере можно будет вернуться к оригинальной странице с фенами.

Что дальше?

Теперь можно пользоваться результатом вывода и скопировать список себе в эксель таблицу, например. Потом можно почистить дубли до получения уникальных ссылок. Можно попробовать отделить ссылки по типу «внешние/внутренние«.

Можно поискать применение «фрагмента» URI (это решётка #) на предмет качественной разметки страницы. Как правило большие страницы, в которых много контента имеют дополнительную семантическую разметку при помощи фрагмента URI. То есть любой пользователь может получить ссылку на конкретный фрагмент текста в документе. (как правило это будет текст на HTML-странице)

Можно поискать «непопрятанные» ссылки на технические разделы сайта, которыми пользуются разработчики. Из них можно «подолбить» админ-панели на попытку входа в систему. Ну и т.д.. Информация о ссылочном профиле страницы может оказаться полезной.

Для кого эта статья?

Эта статья создана в образовательных целях, чтобы укрепить навыки программирования на JavaScript, а также поработать с готовыми API. Статья будет очень полезна тем людям, которые никогда не слышали слово JavaScript и которые ищут способы «Как собрать все ссылки со страницы?» или «Как извлечь все ссылки из HTML?». Эти люди знают свои потребности, но не знают о способах их реализации.

Ссылки

Читайте перевод полной версии стандарта «объектной модели документа», чтобы ознакомиться со всеми концепциями и интерфейсами.

DOM — Living Standard — https://dom.spec.whatwg.org

Читайте официальную документацию живого стандарта «объектной модели документа», чтобы быть в курсе последних изменений.

Для этого в браузерах существует специальная функция – режим просмотра исходного кода страницы.

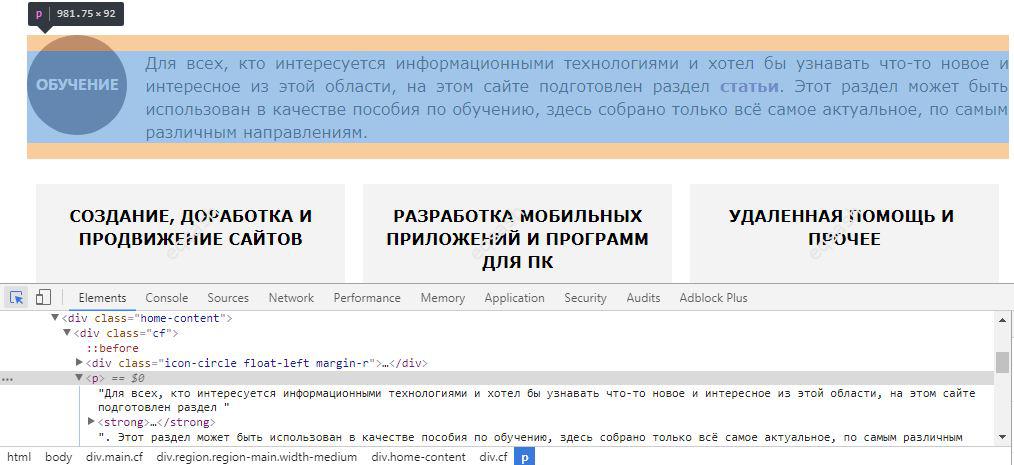

Просмотреть исходный код страницы обычно можно двумя способами – просто открыть его в отдельной вкладке, либо же открыть консоль разработчика, встроенную в браузер и перейти во вкладку просмотра кода.

Первый вариант позволит просто просмотреть код, для этого можно нажать правую кнопку мыши на странице и выбрать пункт меню, который примерно называется «Просмотр кода страницы» или же нажать горячее сочетание клавиш – обычно CTRL + U. Второй же способ предоставляет богатую функциональность для управления исходным кодом страницы. Он и будет рассмотрен ниже на примере браузера Google Chrome.

Находясь на странице сайта, можно навести на элемент и нажать правую клавишу, затем выбрать «Просмотреть код». Такой подход хорош тем, что сразу открывается консоль в нужной вкладке и устанавливается позиция на данный элемент, что позволяет не тратить время на отыскивание элемента среда всего кода.

Аналогично можно открыть консоль и нажать на кнопку в самом верхнем левом углу консоли или сочетание клавиш CTRL + SHIFT + C – в результате браузер перейдет в режим подсветки элементов при наведении на них курсора. После наведения остается кликнуть по элементу и в консоли будет установлена позиция на нужный элемент.

Консоль позволяет выполнять большое количество операций над элементами и предоставляет дополнительный функционал. Она позволяет:

Перечислены лишь только некоторые возможности, которые предоставляет консоль разработчика, встроенная в браузер.

Как видно из статьи, используя только лишь современный браузер, можно досконально изучить исходный HTML-код любой страницы сайта, а также выполнить разнообразные манипуляции над кодом. Все это может помочь разработчикам различных уровней подготовки разрабатывать проекты более эффективно.